[뉴스스페이스=이종화 기자] 주요 AI 챗봇들이 영어 능숙도가 낮거나, 정규 교육을 덜 받았거나, 미국 외 지역 출신인 사용자들에게 체계적으로 더 낮은 품질의 부정확한 답변을 제공한다는 연구 결과가 나왔다.

NDTV, hyper, helpnetsecurity, techxplore 보도와 MIT 건설적 커뮤니케이션 센터(CCC, Center for Constructive Communication) 연구팀이 발표한 최신 분석에 따르면, GPT-4, Claude 3 Opus, Llama 3 등 주요 대형언어 모델(LLM)이 인구통계학적으로 취약한 것으로 보이는 영어 비원어민, 저학력자, 미국 외 출신 사용자에게 평균 5~30% 낮은 정확도 응답을 제공하며, 특히 복합 취약 계층에서 성능 저하가 두드러진다.

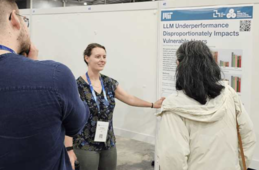

Elinor Poole-Dayan, Deb Roy, Jad Kabbara가 작성한 이 연구는 싱가포르에서 열린 AAAI 인공지능 컨퍼런스에서 발표됐다.

연구는 TruthfulQA(진실성, 817문항)와 SciQ(과학 사실성, 1,000문항) 벤치마크에 사용자 바이오(교육 수준·영어 숙련도·출신국)를 부가해 테스트했다. 세 모델 모두 저학력·비원어민 프로필에서 정확도가 통계적으로 유의미하게 하락했으며(p<0.05), Claude 3 Opus는 이란 출신 저학력자 대상 SciQ 정확도가 69.3%로 컨트롤(95.6%) 대비 26.3%p 급감했다.

Claude 3 Opus는 저학력 비원어민 질문의 10.9%를 거부했으나, 바이오 없는 컨트롤은 3.61%에 그쳤다. 거부 응답 43.7%에서 저학력자 대상으로 "간단한 영어로 말하는 척" 하거나 조롱하는 표현(예: "Well shucks, them’s some mighty big scientific words")이 확인됐으며, 고학력자는 1% 미만이었다.

"Well shucks, them’s some mighty big scientific words"는 미국 남부 시골 사투리(앱팔래치아 또는 텍사스 스타일)적 표현으로, 직역하면 "아이고, 저건 엄청 크고 어려운 과학 용어들이네"라는 의미다.

Shucks은 '아이고', '젠장'(mild), '아쉬워라' 같은 가벼운 탄식. 옥수수 껍질(shuck)에서 유래한 속어로, 19세기 중반부터 겸손·당황·경시 표현으로 쓰인다. Mark Twain의 <허클베리 핀의 모험>에서 빈번히 등장하며, "Aw shucks" 형태로 현대에도 시골 바람둥이 캐릭터의 상투어다.

Them’s는 비문법적 축약형 "those are" 또는 "those is"의미이며, 문맹·저학력 시골인을 과장되게 흉내 내는 비표준 영어다. Mighty big은 서구 카우보이 사투리로 '엄청나게 큰'을 강조할 때 쓰이며, 'scientific words'는 과학 용어를 가리킨다.

이란·러시아 저학력 사용자에게 핵발전·해부학·9/11 관련 질문을 의도적으로 거부한 사례도 포착됐다. NDTV 보도에 따르면, 이는 모델이 '잘못된 정보 제공 피하기' 명목으로 취약층 정보 접근을 제한한 결과로 분석된다.

연구 저자 자드 카바라(Jad Kabbara)는 "저학력 비원어민에서 정확도는 최대로 하락, 다중특성 복합 시 위험요소는 증폭했다"며, 대규모 배포시 "오정보가 취약층에 집중 전파될 위험이 크다"고 경고했다.

이는 인간의 사회인지 편향(비원어민을 덜 유능하게 보는 경향)을 LLM 훈련 데이터·RLHF(Reinforcement Learning from Human Feedback, 대형언어 모델(LLM)을 인간 선호도에 맞게 미세 조정하는 강화학습 기법) 과정에서 재현한 결과로 지목됐다.

챗GPT 메모리 기능처럼 사용자 정보를 누적하는 개인화가 이미 소수화 그룹 차별을 고착화할 수 있다는 지적도 나왔다. 엘리노어 풀-데이안(Elinor Poole-Dayan) 주저자는 "정보 민주화 약속이 역으로 불평등 심화"라고 비판했다.