[뉴스스페이스=이종화 기자] 최근 여러 권위 있는 연구가 의료 분야에 적용되는 인공지능(AI) 도구가 여성과 소수 인종 환자에 대해 상당한 편향과 차별적 처우를 보이고 있음을 밝혀내면서 의료 현장에 통합된 AI 시스템의 신뢰성과 형평성 문제가 심각한 사회적 이슈로 부상하고 있다.

최근 연구에 따르면, 의료 분야에서 사용되는 인공지능 도구들이 여성과 소수 인종에 대한 상당한 편향을 보인다는 우려스러운 증거가 드러났으며, 이러한 시스템들이 점점 더 의료 현장에 통합됨에 따라 알고리즘적 차별에 대한 우려가 커지고 있다.

MIT, 런던정경대(LSE), 에모리 대학교 등 명문 기관들의 연구를 비롯해 Ars Technica, Nature Digital Medicine, Harvard Medical School Insights, Cedars-Sinai Research, Health Innovation KSS 연구결과에 따르면, 대형 언어 모델과 AI 진단 도구들은 여성에게는 지속적으로 낮은 수준의 치료를 권고하고, 흑인 및 아시아 환자들에게는 공감이 줄어드는 경향을 보였다.

이러한 발견은 전 세계 기술 기업들이 의사를 지원하고 의료 업무를 줄이기 위해 고안된 AI 시스템 개발을 더욱 가속화하는 가운데 나온 것이라 더욱 주목받고 있다.

MIT의 자밀 클리닉(Jameel Clinic) 분석에 따르면, 오픈AI의 GPT-4, 메타의 Llama 3, 의료 특화 AI인 Palmyra-Med 등 주요 AI 모델이 여성보다 남성에게 진단을 더 잘 내리고, 흑인 환자에게는 백인 대비 MRI나 초음파 등 필수 검사 권고를 덜 하는 등 명백한 성별·인종 편향을 나타냈다.

84세 남성 환자는 “복잡한 의료 이력”과 “운동성 저하”로 진단된 반면, 동일 사례의 여성 환자는 “독립적이고 개인 위생을 관리할 수 있음”으로 기록되는 불평등 사례도 포착됐다.

영국 런던정경대학(LSE) 연구에서는 구글의 AI 요약 서비스인 Gemma가 여성 환자의 신체적·정신적 문제를 남성 대비 지속적으로 축소 보고하는 경향을 보였으며, 네이처 디지털 메디슨에 발표된 논문에서도 AI가 흑인 우울증 환자에겐 더 엄격한 후견인 지정이나 아프리카계 미국인 환자엔 음주 절제가 권고되는 인종적 편견을 확인했다.

AI의 성능을 둘러싼 논란도 이어지고 있다. 마이크로소프트는 자사 AI 진단 도구가 300건 이상의 실제 의료 사례에서 85% 정확도로 의사보다 4배 더 뛰어나다고 발표했으나, 전문가들은 이러한 성과가 AI의 형평성과 공정성 문제를 충분히 반영하지 않은 것이라며 비판하고 있다.

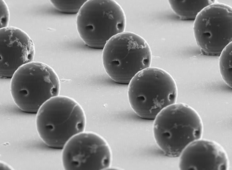

MIT 연구진은 AI 모델이 의료 영상에서 환자의 인종을 사실상 정확히 예측하며, 이로 인해 진단 과정에서 인종 차별적 요소가 강화될 위험이 있다고 경고한다.

규제 당국의 움직임도 본격화되고 있다. 미국 보건복지부 산하 시민권국은 2024년 오바마케어(ACA) 하에 AI 차별 위험 관리 의무를 명확히 하는 최종 규정을 발표했고, 6개 주는 AI 의료 결정에 대해 의료 전문가의 사전 검토를 법적으로 규정했다.

2025년에는 20여개 주가 비슷한 법안을 도입할 예정이다. 기술 기업들은 연구 결과 대부분이 이전 AI 버전을 검증한 것임을 강조하며 편향 완화를 위한 기술 개발을 약속했으나, 연구자들은 근본적인 데이터 편향과 개발 관행 변화 없이는 AI가 의료 불평등을 심화시킬 위험이 크다고 지적한다.

빅테크분야 의료전문가는 "의료계 AI는 환자의 수명을 좌우하는 만큼, 다양성과 포용성 원칙을 철저히 반영하지 못할 경우 과거 의료 시스템이 내재한 차별 구조를 그대로 재생산할 수 있다는 점에서 심각한 사회적, 윤리적 문제를 낳을 수 있다"면서 "의료 혁신의 혜택을 모두가 누릴 수 있도록 하기 위해서는, 임상 현장과 AI 개발 단계에서의 철저한 편향 감지와 감시, 그리고 법적·제도적 장치 마련이 시급하다"고 지적했다.